Nový zákon EÚ o umelej inteligencii predstavuje zásadný posun v regulácii AI – jeho cieľom je zabezpečiť, aby systémy umelej inteligencie používané v Európe boli bezpečné, transparentné a rešpektovali základné práva. Ide o rámec založený na hodnotení rizika, ktorý rozdeľuje AI systémy do štyroch kategórií: neprijateľné riziko, vysoké riziko, obmedzené riziko a minimálne riziko. Dodržiavanie týchto pravidiel nie je len právnou povinnosťou, ale strategickou nevyhnutnosťou. Ovplyvňuje totiž dôveru, reputáciu značky aj dlhodobú konkurencieschopnosť.

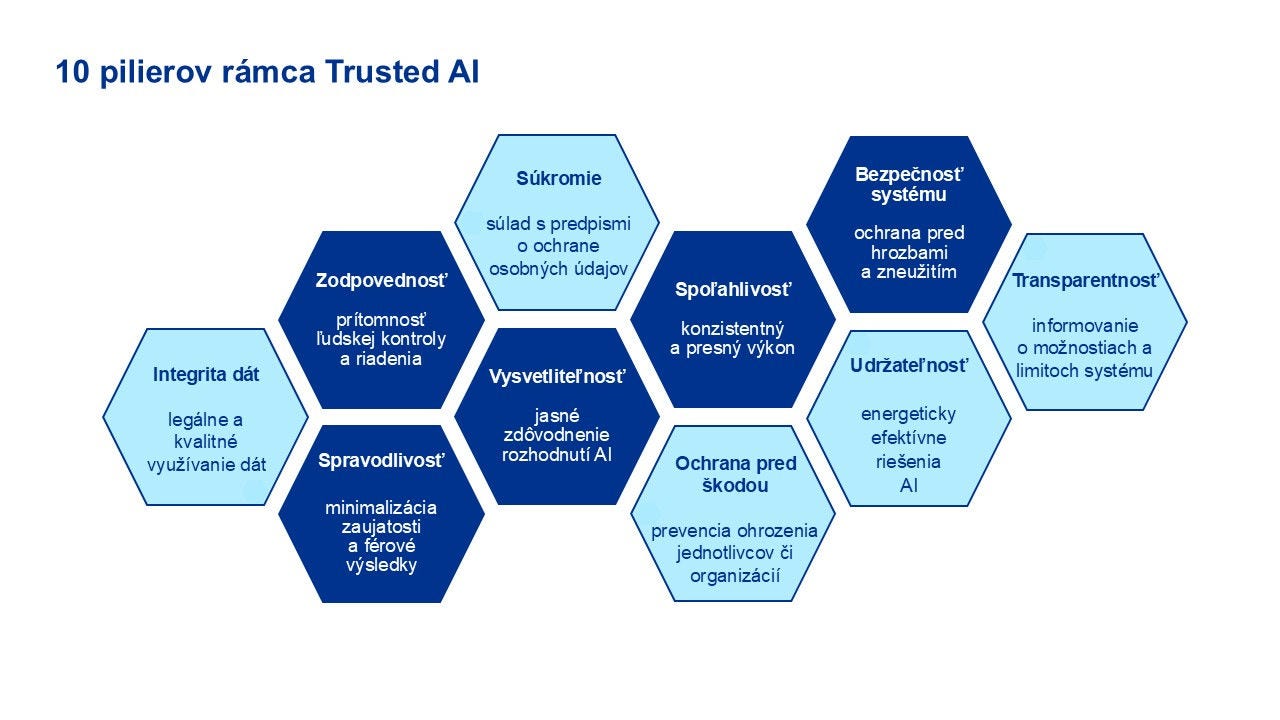

Kľúčové dôsledky legislatívy zahŕňajú povinné posudzovanie súladu s pravidlami pri systémoch s vysokým rizikom, povinnosti v oblasti transparentnosti pri systémoch komunikujúcich s ľuďmi, prísnu správu dát a dokumentačné požiadavky, ale aj mechanizmy manuálnej ľudskej kontroly a zodpovednosti. Na tieto požiadavky reaguje aj rámec Trusted AI spoločnosti KPMG, ktorý ponúka ucelený prístup k riadeniu rizík, etickému používaniu AI a správnemu nastaveniu pravidiel.

Uplatňovanie týchto princípov koordinuje Trusted AI Council – rada, ktorá dohliada na jednotlivé pravidlá, hodnotenie rizík a súlad s reguláciami.

Autor článku

Alexander Zagnetko

Manager

Process Organization and Improvement

Hodnotenie rizík podľa AI Act-u

V prípade hodnotenia rizík je na mieste posúdenie použitia daného nástroja alebo technológie, a to z pohľadu zdrojov dát, procesov rozhodovania a celkového spoločenského dopadu. Jednotlivé kroky hodnotenia zahŕňajú:

- Posúdenie pripravenosti: zhodnotenie stavu riadenia, dát, technológií a firemnej kultúry.

- Stanovenie priorít pre jednotlivé použitia: identifikácia rizikových aplikácií a ich vystavenia reguláciám,

- Analýza nedostatkov: porovnanie súčasnej praxe s požiadavkami AI Act-u.

- Hodnotenie účinnosti kontrol: preverenie bezpečnostných opatrení, monitoringu a krízových mechanizmov.

Pri výbere vhodných AI riešení by mali organizácie hľadať rovnováhu medzi biznisovým prínosom, technickou uskutočniteľnosťou a reguláciou. Je preto dôležité zamyslieť sa nad niekoľkými otázkami. Podporuje riešenie ciele organizácie? Sú dátové zdroje legálne, etické a kvalitné? Je technické prostredie bezpečné a škálovateľné? Sú externí dodávatelia v súlade s pravidlami AI riadenia?

Pri využívaní umelej inteligencie je tiež potrebné zvážiť viacero aspektov: ak AI výrazne ovplyvňuje prístup ľudí k službám, zamestnaniu, úverom, vzdelaniu či zdravotnej starostlivosti, ide o vysoké riziko a vyžaduje si prísnejšie kontroly. Ak dokáže generovať obsah, napodobňovať ľudí alebo vytvárať tzv. deepfake obsah, je potrebné zabezpečiť transparentnosť prostredníctvom jasného označovania, overiteľnosti a moderácie. Ak ide o autonómnych AI agentov pracujúcich so systémami či dátami, je nutné nastaviť ochranné mantinely – obmedziť prístupy, využívať izolované prostredie, pracovať len so schválenými nástrojmi a zabezpečiť priebežný monitoring.

Súlad s predpismi nemôže byť len dodatočnou kontrolou, ale musí byť pevnou súčasťou celého životného cyklu vývoja umelej inteligencie – od automatizovaného porovnávania interných predpisov s regulačnými požiadavkami cez dôslednú dokumentáciu a overiteľnosť dát a rozhodnutí až po priebežný monitoring s upozorneniami v reálnom čase a pravidelné školenia zamerané na riziká a očakávania regulátorov.

Umelá inteligencia v neposlednom rade prináša nové riziká z pohľadu kybernetickej bezpečnosti. Odporúčame preto organizáciám chrániť svoje prístupy a rozhrania, cez ktoré AI komunikuje so zákazníkmi, mať pod kontrolou dáta aj prostredie, v ktorom systém beží, a dôkladne preverovať spoľahlivosť svojich dodávateľov a partnerov.

Päť častých otázok

Nový zákon o umelej inteligencii sa už zmenil z konceptu na reálny režim s presadzovaním pravidiel a podpornými nástrojmi. Najúspešnejšie firmy nebudú tie, ktoré si len splnia svoju zákonnú povinnosť, ale tie, ktoré dokážu vybudovať dôveru – vďaka spoľahlivému uvádzaniu produktov na trh, lepším vzťahom s regulátormi a rýchlejším obchodným výsledkom. Pre európsky rast aj globálne značky predávajúce v Európe je to investícia, ktorá sa oplatí.

V KPMG staviame náš prístup k AI na dôvere, transparentnosti a transformácii. Vďaka rámcu Trusted AI a znalostiam z jednotlivých odvetví pomáhame organizáciám nielen splniť si nové pravidlá, ale aj rozvíjať potenciál umelej inteligencie zodpovedným spôsobom.

Kontaktujte našich odborníkov

Ak si želáte viac informácií o tom, ako môžeme pomôcť vášmu podniku, prípadne ak si chcete dohodnúť stretnutie, kontaktujte nás.