Aj keď je tzv. všeobecná umelá inteligencia (z angl. artificial general intelligence, AGI) ešte stále v nedohľadne, už dnes existujú modely a riešenia, ako napríklad veľké jazykové modely (LLM) či generatívna AI, ktoré vyvolávajú vážne otázky. Tieto systémy nie sú založené len na pevne daných pravidlách, ale dokážu sa učiť z dát a v ich správaní sa objavujú nové, nepredvídané vzorce. Práve táto zložitosť robí trh s umelou inteligenciou mimoriadne citlivým na reguláciu, a to oveľa viac než v prípade predchádzajúcich technologických zmien. Nastaviť jasné hranice a účinnú kontrolu je preto obrovská výzva.

Európsky zákon o umelej inteligencii (AI Act) je krokom k zodpovednému riadeniu technológií. Jeho úspech však závisí od toho, či sa bude dať uplatňovať v praxi, či prinesie jasné pravidlá a či dokáže podporiť inovačné prostredie. Rizikom je byrokracia, ale aj príliš slabá regulácia. Skutočnou výzvou teda nie je rozhodnúť sa medzi etikou a inováciami, ale vytvoriť reálny rámec, ktorý sa bude vyvíjať spolu s technológiou a zároveň chrániť spoločenské hodnoty.

Autor článku

Alexander Zagnetko

Manager, Process Organization and Improvement

Ako dosiahnuť súlad s pravidlami?

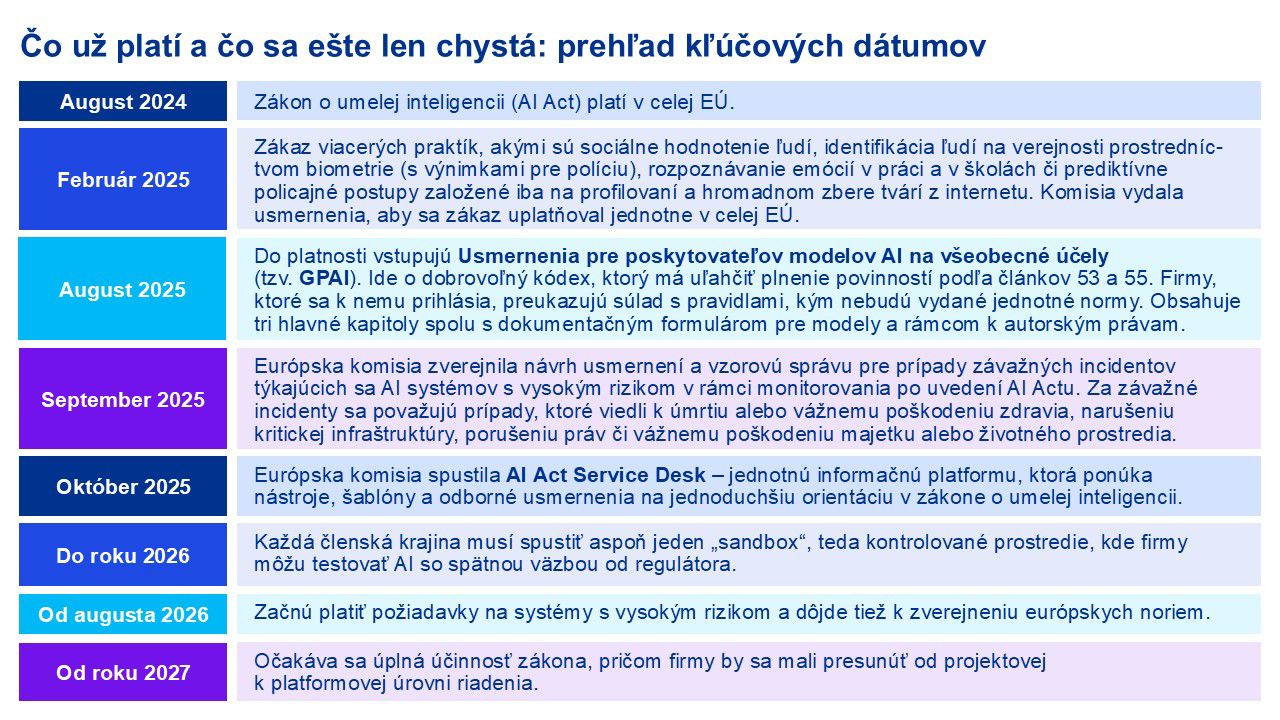

Zákon o umelej inteligencii v EÚ vstúpil do platnosti 1. augusta 2024 a stal sa prvým komplexným rámcom na svete, ktorý reguluje AI na báze rizikovosti. Odvtedy sa toho udialo veľa: od 2. februára 2025 platia prvé zákazy, od augusta 2025 pribudli povinnosti pre všeobecné modely AI (Usmernenia pre poskytovateľov modelov AI na všeobecné účely, tzv. GPAI), v auguste 2026 začnú platiť požiadavky pre systémy s vysokým rizikom a od roku 2027 má byť legislatíva plne účinná. Nový Európsky úrad pre AI má na starosti dohľad, najmä nad GPAI, a spolu s Komisiou pripravuje metodiky, kódexy správania a technické normy.

Pre lídrov vo firmách je odkaz jasný: k dodržiavaniu pravidiel treba pristupovať ako k riadeniu produktu. Znamená to vybudovať funkčný kontrolný systém pre AI – od hodnotenia rizík, dokumentácie modelov a sledovania pôvodu dát, cez ľudský dohľad v kľúčových rozhodnutiach a bezpečný životný cyklus modelov, až po testovanie odolnosti a sledovanie prevádzky po nasadení. Tento systém sa má zároveň prepojiť s existujúcimi programami ochrany súkromia, kyberbezpečnosti či produktovej bezpečnosti (napr. GDPR, NIS2 či Data Act). Len tak sa dá riadiť riziko a nebrzdiť vývoj nových funkcií v prostredí plnom pravidiel, ktoré sa stáva európskym štandardom.

Čo znamená prístup založený na riziku?

Regulácia umelej inteligencie v EÚ je postavená na prístupe založenom na riziku, a teda povinnosti a pravidlá sa odvíjajú od závažnosti možných dopadov jej použitia.

Neprijateľné riziko, aké predstavuje napríklad sociálne hodnotenie alebo manipulatívna AI, je úplne zakázané a Európska komisia vydala usmernenia, aby sa zákaz uplatňoval jednotne v celej EÚ. Ak váš projekt spadá do tejto kategórie, musíte ho okamžite zastaviť alebo prerobiť. Do kategórie vysokého rizika patrí AI využívaná pri prijímaní do práce, vo vzdelávaní, pri poskytovaní úverov, v zdravotníctve či v kritickej infraštruktúre. Takéto systémy musia spĺňať prísne požiadavky na riadenie rizík, správu dát, transparentnosť, ľudský dohľad a kyberbezpečnosť a môžu byť uvedené na trh len po preverení, či spĺňajú všetky pravidlá a získaní oficiálneho označenia CE. Obmedzené riziko sa týka napríklad chatbotov či generatívnej AI, ktoré musia jasne informovať používateľov o tom, že komunikujú so strojom, a zároveň označovať vytvorený obsah.

Za porušenie pravidiel hrozia vysoké pokuty – pri najvážnejších prehreškoch až do 35 miliónov eur alebo 7 % celkového ročného obratu firmy, pričom menej závažné porušenia podliehajú nižším sankciám.

Prepojenie s inými predpismi

Používanie umelej inteligencie je úzko prepojené aj s ďalšími európskymi predpismi. GDPR kladie dôraz na to, aby spracovanie osobných údajov s využitím AI malo zákonný základ, bolo férové, transparentné a presné. Nariadenie Data Act platné od 12. septembra 2025 posilní prenositeľnosť dát, umožní jednoduchšie prepínanie medzi poskytovateľmi cloudu a podporí vzájomnú kompatibilitu, čo je kľúčové najmä pre digitálnych asistentov. Z pohľadu kyberbezpečnosti je dôležité opierať sa o analýzy a odporúčania európskej agentúry ENISA, ktorá poskytuje usmernenia k špecifickým hrozbám a opatreniam pre AI systémy. Regulácia ide zároveň ruka v ruke s budovaním infraštruktúry, napríklad vysokovýkonnej výpočtovej techniky EuroHPC, ktorá má podporiť bezpečný vývoj umelej inteligencie.

Premýšľate o automatizácii pomocou AI? Na čo si dať pozor

Nový zákon o umelej inteligencii (AI Act) síce neurčuje, aký model máte použiť, no zásadne mení spôsob, akým sa pri ich výbere budete rozhodovať. Inými slovami: technológia už nie je len otázkou funkčnosti, ale aj súladu s pravidlami, bezpečnosti a dôveryhodnosti.

Pozrime sa na päť typických oblastí, kde sa AI najčastejšie využíva a čo by ste pri nich mali mať na pamäti:

Marketingové texty, chatboty či zákaznícka podpora musia byť jasne označené ako AI výstupy. Používajte overené modely s kvalitnou dokumentáciou a dodržiavaním autorských práv. Nastavte filtre a kontrolné mechanizmy, ktoré zabránia nevhodným odpovediam, a nechajte priestor na zásah človeka.

Nábor zamestnancov, schvaľovanie úverov alebo posudzovanie nárokov na dávky patria medzi oblasti s vysokým rizikom. Táto kategória vyžaduje špecializované modely s presnou dokumentáciou. Pri využívaní všeobecných modelov (GPAI) je potrebné pridať mechanizmus, ktorý dokáže vysvetliť prijaté rozhodnutia a ponecháva priestor na ľudský dohľad. Súčasťou procesu je aj testovanie zaujatosti a pravidelné monitorovanie.

V priemysle, doprave či v zdravotníctve je nevyhnutné, aby AI zapadala do prísnych režimov produktovej bezpečnosti. Vyberajte dodávateľov, ktorí dokážu preukázať súlad s európskymi normami (CE označenie) a počítajte s nezávislým hodnotením zo strany certifikačných orgánov. Systémy musia mať záložné mechanizmy a byť dôsledne sledované aj po nasadení.

Nástroje na podporu produktivity, programovanie alebo výskum prinášajú rozsiahle možnosti, ale zároveň otvárajú otázky týkajúce sa práce s dátami. Využívajte modely, ktoré udržia vaše firemné údaje v bezpečí. Overte, že dodávateľ poskytuje informácie o tréningových dátach a umožňuje prenos dát podľa nového európskeho Data Actu. Samozrejmosťou sú opatrenia na ochranu súkromia a školenie zamestnancov.

Teda systémy, ktoré samostatne plánujú činnosti a používajú rôzne nástroje, sa považujú za najrizikovejšie. Ich vývoj by mal začať v tzv. sandboxoch, teda regulačných prostrediach, kde sa testujú pod dohľadom úradov. Musia absolvovať prísne bezpečnostné testy a disponovať zoznamom povolených funkcií či núdzovými „vypínačmi“.

Kľúčové odporúčania pre lídrov

- Zaveďte jednotný systém riadenia AI – napríklad podľa normy ISO/IEC 42001. Vďaka nemu zosúladíte bezpečnosť, ochranu súkromia aj práva používateľov.

- Zapojte dodávateľov do zodpovednosti – vyžadujte od nich dokumentáciu, prehľad tréningových dát a pravidlá k autorským právam premietnite priamo do zmlúv.

- Ľudský dohľad musí fungovať v praxi – jasne určte, kto a ako zasahuje, vzdelávajte hodnotiteľov a testujte, či kontrolné mechanizmy naozaj fungujú.

- Pravidelne testujte odolnosť – overujte, ako vaše modely a procesy reagujú na riziká a či zvládnu nepretržitú prevádzku.

- Pripravte sa na riadenie modelov vo veľkom – centralizujte dokumentáciu a evidenciu incidentov, automatizujte logovanie aj monitorovanie.

- Využívajte testovacie prostredia („sandboxy“) strategicky – nové a komplexné riešenia skúšajte v spolupráci s regulátormi. Dobre vedená dokumentácia vám uľahčí vstup na trh.

- Myslite na reputáciu aj pokuty – pri hrozbe sankcií až do 35 miliónov eur alebo 7 % z obratu je dodržiavanie pravidiel neoddeliteľnou súčasťou obchodného modelu.

Kontaktujte nás

Ak si želáte viac informácií o tom ako môžeme pomôcť vášmu podniku, prípadne ak si chcete dohodnúť stretnutie kvôli osobnej prezentácii našich služieb, kontaktujte nás.