Cet article a été rédigé par : Romain Lamotte, Bertrand Aubry & Vincent Maret.

La création d'un outil d'IA générative demande beaucoup de temps, d'argent et d'efforts. C'est pourquoi, pour l'instant, la plupart des entreprises ont recours à des solutions d'IA générative tierces, telles qu'OpenAI et Stability AI, s’exposant à un risque accru de fraude ou de vol d'informations propriétaires ou privées. Lorsque ce ne sont pas les entreprises elles-mêmes qui y font appel, ce sont les employés qui passent par ce type de technologies, ajoutant à ces risques ceux d’une perte d’esprit critique dans l’exploitation des résultats et d’une opacité dans la gestion de leur temps.

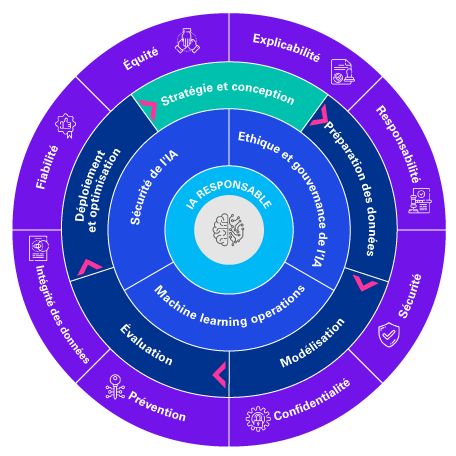

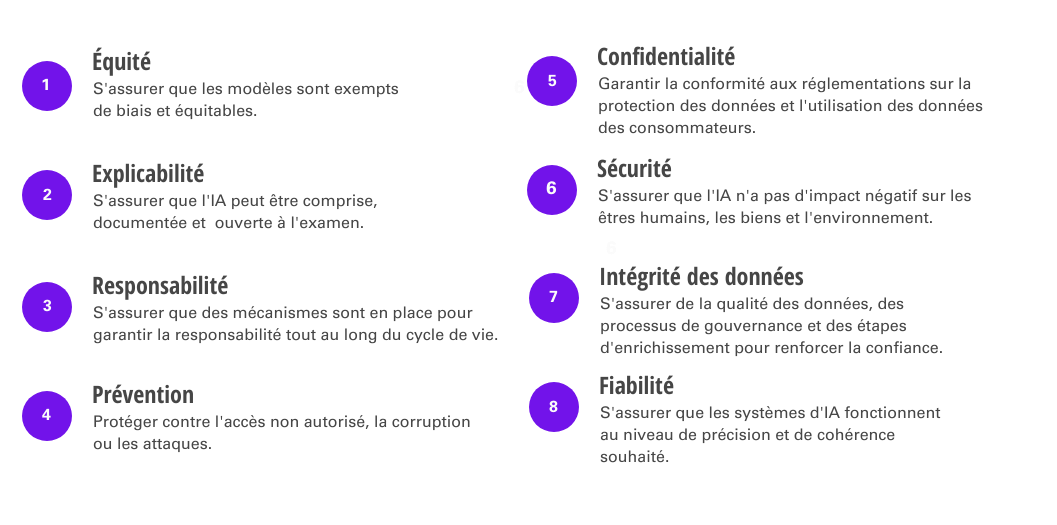

Dans ce deuxième article de notre série consacrée aux applications d'IA générative, nous nous penchons sur la nature et la gestion des risques qu’elles comportent pour l’interne et l’externe. Nous soulignerons l'importance, pour les entreprises, de les identifier et de mettre en place des structures de gouvernance en favorisant une adoption responsable et une utilisation qui préserve la confiance dans ces technologies.

Risques d’origine interne

Propriété intellectuelle

La technologie de l'IA générative utilise des réseaux neuronaux qui peuvent être entraînés sur de grands jeux de données existants pour créer de nouvelles données ou objets, comme des textes, des images ou des sons. Cela comprend les données entrées par ses différents utilisateurs, que l'outil conserve pour continuellement améliorer son apprentissage et sa base de connaissances. Ces données pourraient à leur tour être utilisées pour répondre à une demande formulée par quelqu'un d'autre, exposant potentiellement des informations privées ou propriétaires au public. Plus les entreprises utilisent cette application, plus il est probable que leurs informations puissent être accessibles par d'autres. De plus, le contenu généré par l'IA en réponse aux demandes d'une entreprise pourrait contenir la propriété intellectuelle d'une autre entreprise. Cela pourrait entraîner des ambiguïtés concernant la paternité et la propriété du contenu généré, suscitant des accusations possibles de plagiat ou le risque de poursuites pour violation du droit d'auteur.

Utilisation abusive des employés

L'utilisation de l'IA générative offre aux entreprises de nombreux avantages, mais elle présente également de puissantes tentations d'abus par les employés. Les employés pourraient être tentés d'utiliser l'IA générative et de faire passer le résultat pour leur propre travail. Un exemple sérieux d'utilisation abusive serait l’automatisation de confirmations ou de revues juridiques, ne prenant pas en compte des considérations éthiques, réglementaires ou d’indépendance importantes, ce qui pourrait engager la responsabilité légale de l’entreprise.

Résultats imprécis

Même l'utilisation légitime de l'IA générative comporte des risques. Les employés qui utilisent l'IA générative devront faire preuve de vigilance en évaluant la qualité des résultats et en y appliquant un esprit critique professionnel. En s’appuyant sur une base de connaissances existante, les solutions d’IA Générative sont par exemple susceptibles de reproduire des biais historiques, et sont peu adaptées pour générer des contenus véritablement « nouveaux ». Une exploitation de résultats imprécis peut entraîner de mauvaises prises de décisions, impacter la réputation de l’entreprise et créer des risques légaux.

Risques d’origine externe

Les actions malveillantes sont légion sur le web, et l’IA générative peut faciliter leur exécution tout en les rendant bien plus difficiles à détecter.

L'IA générative peut également être utilisée pour créer ce que l'on appelle des images ou des vidéos deepfake, avec un réalisme troublant et sans laisser de traces forensiques, ce qui les rend difficiles à détecter. Ce type de support pourrait par exemple représenter une entreprise dans une situation scandaleuse ou encore servir de preuve pour des réclamations d'assurance frauduleuses.

Enfin, l'IA générative soulève également des risques en matière de cybersécurité. Les cybercriminels peuvent utiliser cette technologie pour créer des escroqueries au phishing plus réalistes et sophistiquées, ou pour générer des identifiants leur permettant de pirater des systèmes.